FAQ sur les réponses génératives

La mise à l'échelle des projets d'IA générative au sein d'une entreprise s'accompagne de plusieurs défis. Un problème courant est la fragmentation causée par de multiples équipes menant des projets de validation de concept (POC) en silo. Ces efforts déconnectés conduisent souvent à une duplication du travail, à des pipelines de données incohérents et à des bases de connaissances fragmentées.

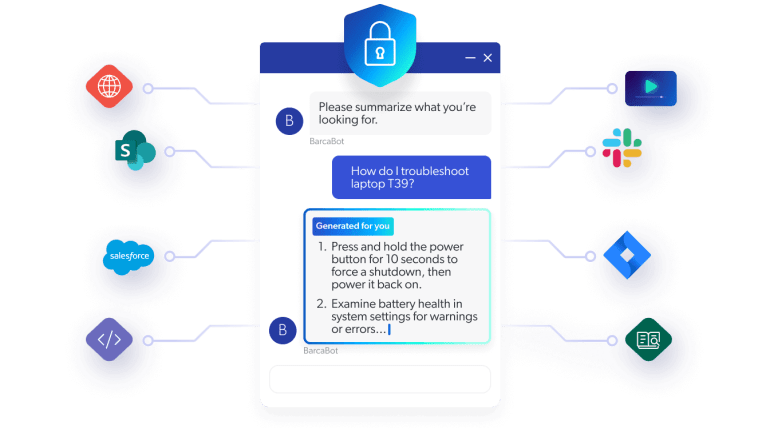

Lasécurité et la conformité sont également des obstacles importants, car les données d'entreprise nécessitent des contrôles d'accès stricts et doivent respecter les normes réglementaires, ce qui complique la création et la maintenance de pipelines sécurisés.

En outre, l'intégration de diverses sources de données aux formats et API variés est complexe et nécessite une maintenance permanente pour éviter les données périmées ou les problèmes de connexion.

Enfin, l'évolutivité est difficile à obtenir, car les systèmes de production doivent gérer des millions d'utilisateurs et de documents tout en maintenant des performances et une fiabilité élevées.

La réalité de l'entreprise : Le déploiement de la GenAI pour des cas d'utilisation réels est bien plus complexe qu'une preuve de concept ou une démonstration rapide. Bien que beaucoup aient investi dans la formation de leurs propres LLM, la sécurité, l'évolutivité et la qualité des données sont des préoccupations constantes.

L'écart de récupération : la génération augmentée de récupération (RAG) est largement vantée comme le moyen d'ancrer les LLM dans les données d'une organisation, mais la récupération d'informations est plus difficile que les organisations ne le pensent. De nombreuses équipes sous-estiment les coûts opérationnels liés à la connexion, à la sécurisation et à l'unification des sources de données à grande échelle, ainsi qu'à leur maintenance.

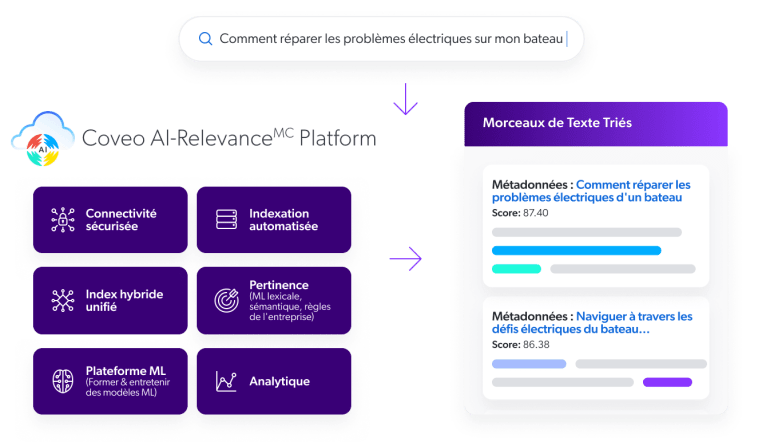

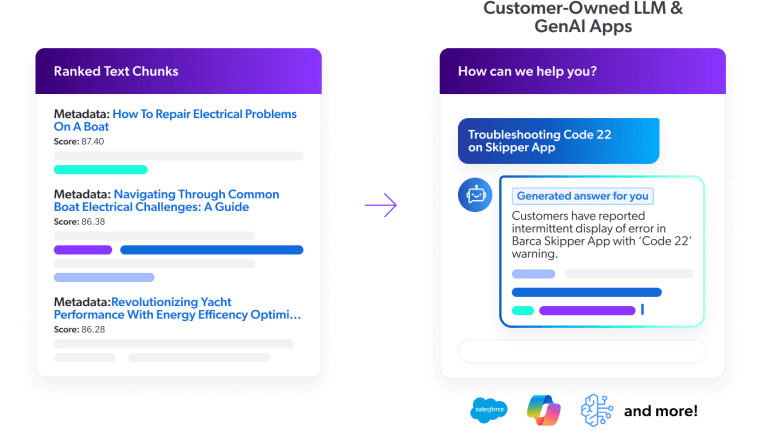

L'extraction est essentielle car elle garantit que les applications d'IA générative reposent sur des données précises, opportunes et pertinentes. Si la création d'invites ou la sélection d'un modèle de langage étendu (LLM) peut être relativement simple, l'alimentation du LLM avec des données de haute qualité est beaucoup plus difficile. Si le système de recherche est défectueux - en raison de données périmées, d'une faible pertinence de la recherche ou de sources fragmentées - les résultats de l'IA ne seront pas fiables, ce qui entraînera des scénarios de type "garbage in, garbage out" (entrée et sortie de déchets). Coveo résout ce problème en indexant les données à travers les silos, en classant les résultats avec l'IA et en appliquant des mesures de sécurité strictes, assurant que le LLM reçoive la meilleure information possible. Cette base d'extraction robuste est ce qui permet des applications d'IA générative évolutives et fiables.

Le choix de la part de vos expériences d'IA générative à construire varie en fonction du client et du cas d'utilisation. Il est courant que les organisations déploient une combinaison de solutions de réponse générative personnalisées et prêtes à l'emploi.

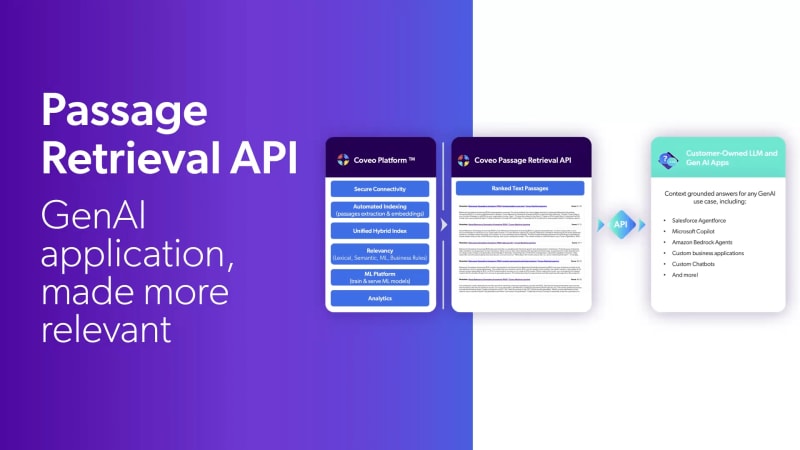

Les raisons de créer des applications d'IA générative personnalisées sont souvent le contrôle de l'interface utilisateur frontale, l'utilisation d'un LLM conçu à cet effet ou formé par l'entreprise, l'intégration à un chatbot ou à un flux de travail agentique, ou un contrôle plus granulaire de l'ingénierie des messages-guides. Dans tous ces cas, la portion de récupération d'information du RAG est la plus difficile à créer et à maintenir ; c'est là que l'API de récupération de Coveo Passage entre en jeu.

Si vous cherchez une solution gérée prête à l'emploi pour les services, les sites Web, les lieux de travail et les cas d'utilisation commerciaux, jetez un coup d'œil à Coveo Relevance Generative Answering. Ce produit tire parti de la même API de récupération, mais offre une expérience de réponse générative prête à l'emploi avec un délai de rentabilité exceptionnel.

Pour unifier et développer les projets Gen AI, il faut regrouper les efforts autour d'un système de recherche d'informations unique et sécurisé. Les POCs fragmentés mènent souvent à un travail dupliqué, à des données fragmentées et à une sécurité incohérente. Une plateforme robuste comme Coveo centralise la recherche, indexe les données à travers les silos tout en assurant un accès sécurisé, pertinent et évolutif. En fondant vos LLM sur une extraction fiable, vous rationalisez les opérations et permettez un déploiement cohérent de l'IA à l'échelle de l'entreprise.

L'évolutivité provient d'une technologie d'entreprise éprouvée, conçue pour les volumes élevés et la complexité. Le moteur d'extraction de Coveo basé sur l'IA assure une performance sécurisée, conforme et fiable pour des millions de documents et d'utilisateurs. Avec des réponses génératives prêtes à l'emploi et des API de récupération personnalisées, le partenariat avec Coveo réduit le temps de développement, diminue les coûts et accélère le retour sur investissement des projets de génération augmentée de récupération, livrant des solutions GenAI percutantes en quelques semaines.